简介

H2O LLM Eval是由H2O.ai开发的一款用于评估和比较大型语言模型(LLM)的工具。它提供了一个平台,使用户能够了解不同模型在广泛任务和基准测试中的表现,帮助用户为特定任务选择合适的模型。

主要功能

模型评估:评估模型在各种任务和基准测试中的表现。

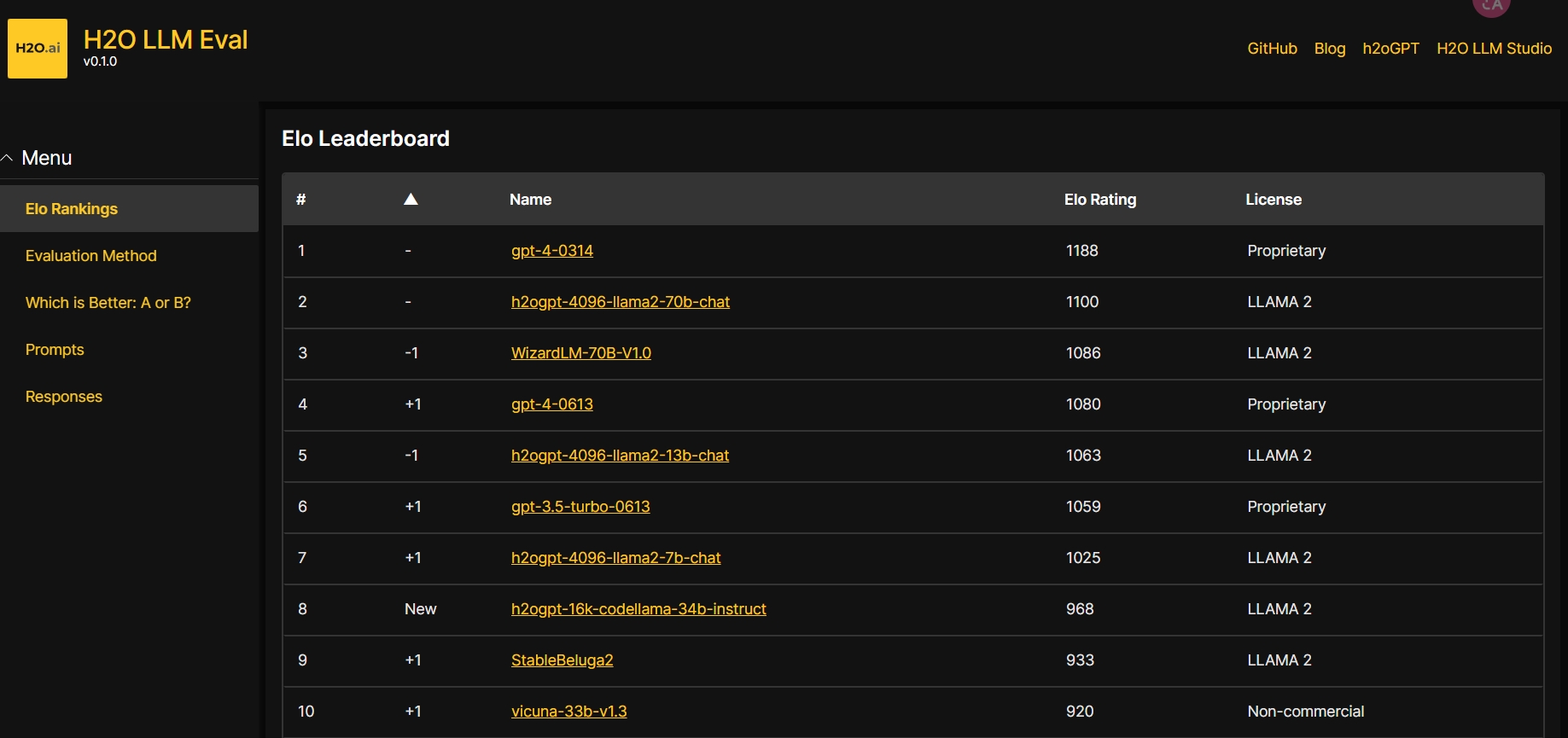

性能排行榜:提供基于性能的模型排名,帮助用户选择最有效的模型。

自动化和响应性:平台自动化更新,快速响应模型提交和评估。

A/B 测试:允许用户手动运行A/B测试,以获得更深入的模型评估见解。

主要特点

相关性:H2O LLM Eval根据行业特定数据评估流行的大语言模型,使用户能够了解模型在实际场景中的表现。

透明度:通过开放的排行榜显示顶级模型评级和详细的评估指标,确保评估过程的完全可重复性。

速度和更新:全自动和响应式平台每周更新排行榜,减少评估模型提交所需的时间。

范围:评估各种任务的模型,并随着时间推移添加新的指标和基准,以全面了解模型的功能。

交互性和人工一致性:提供手动运行A/B测试的能力,确保自动评估和人工评估之间的一致性。

结论

H2O LLM Eval作为一个开放工具,为用户提供了一个高效、透明和自动化的平台来评估和比较大型语言模型。它通过详细的性能评估和排行榜,帮助用户为自动化工作流程或特定任务选择最合适的模型。随着AI技术的不断发展,H2O LLM Eval有望成为推动大型语言模型评估和选择的重要工具。